Mercredi, OpenAI a annoncé la sortie de deux nouveaux modèles – O3 et O4-MinI – qui combinent des capacités de raisonnement simulées avec accès à des fonctions telles que la navigation et le codage Web. Ces modèles marquent la première fois que les modèles axés sur le raisonnement d’OpenAI peuvent utiliser chaque outil Chatgpt simultanément, y compris l’analyse visuelle et la génération d’images.

OpenAI a annoncé l’O3 en décembre et jusqu’à présent, seuls des modèles dérivés moins capables nommés “O3-Mini” et “03-MinI-High” ont été disponibles. Cependant, les nouveaux modèles remplacent leurs prédécesseurs – O1 et O3-MinI.

Openai déploie aujourd’hui l’accès pour Chatgpt Plus, Pro et les utilisateurs de l’équipe, les clients d’entreprise et d’Edu ont accès la semaine prochaine. Les utilisateurs gratuits peuvent essayer O4-MINI en sélectionnant l’option “Think” avant de soumettre des requêtes. Le PDG d’Openai, Sam Altman, a tweeté que “nous nous attendons à libérer O3-Pro au niveau pro dans quelques semaines”.

Pour les développeurs, les deux modèles sont disponibles à partir d’aujourd’hui via l’API CHAT EXCELIONS et les réponses, bien que certaines organisations auront besoin d’une vérification pour l’accès.

“Ce sont les modèles les plus intelligents que nous ayons publiés à ce jour, ce qui représente un changement d’étape dans les capacités de Chatgpt pour tous, des utilisateurs curieux aux chercheurs avancés”, a déclaré Openai sur son site Web. Openai affirme que les modèles offrent une meilleure rentabilité que leurs prédécesseurs, et chacun est livré avec un cas d’utilisation prévu différent: O3 cible l’analyse complexe, tandis que O4-MinI, étant une version plus petite de son modèle SR de nouvelle génération “O4” (non encore libéré), optimise pour la vitesse et la rentabilité.

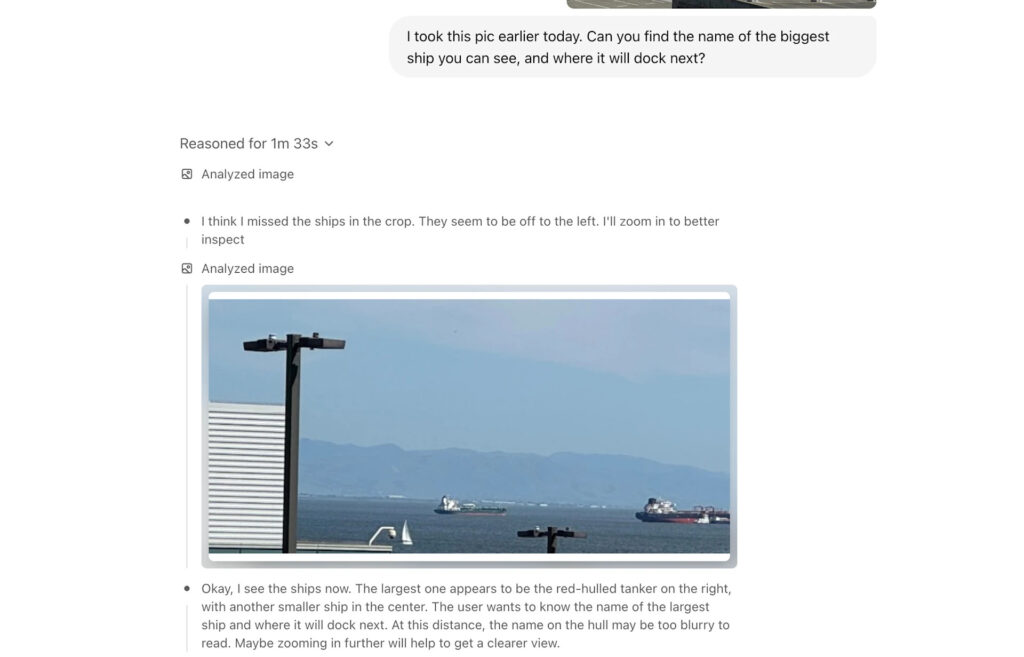

Openai dit que O3 et O4-MinI sont multimodaux, avec la capacité de “penser avec des images”.

Crédit: Openai

Ce qui distingue ces nouveaux modèles des autres modèles d’Openai (comme GPT-4O et GPT-4.5), c’est leur capacité de raisonnement simulée, qui utilise un processus de «réflexion» étape par étape simulé pour résoudre les problèmes. De plus, les nouveaux modèles déterminent dynamiquement quand et comment déployer des aides pour résoudre les problèmes en plusieurs étapes. Par exemple, lorsqu’on leur a été interrogé sur la consommation d’énergie future en Californie, les modèles peuvent rechercher de manière autonome les données des services publics, écrire du code Python pour créer des prévisions, générer des graphiques de visualisation et expliquer les facteurs clés derrière les prédictions, le tout dans une seule requête.